W erze internetu liczącego niemal 2 miliardy stron internetowych, wyszukiwarki stały się nieodzownym przewodnikiem pozwalającym użytkownikom odnaleźć potrzebne informacje. Dla właścicieli witryn oznacza to jedno – walka o czołowe pozycje w wynikach wyszukiwania. Badania wskazują, że 61% internautów szuka produktów online, a 44% z nich używa do tego wyszukiwarek. Co więcej, większość użytkowników zwraca uwagę jedynie na wyniki z pierwszej strony wyszukiwania. W praktyce, jeśli strony nie ma wysoko w Google, dla wielu odbiorców niemal nie istnieje.

Nic dziwnego, że SEO – czyli poprawianie widoczności strony w bezpłatnych wynikach – stało się ważne dla sukcesu w sieci. W przeciwieństwie do płatnych reklam, techniki SEO pozwalają zdobywać wartościowy ruch bez ponoszenia kosztów za każde kliknięcie. Dobrze zoptymalizowana strona nie tylko pojawia się wyżej w rezultatach, ale też lepiej odpowiada na potrzeby odwiedzających ją użytkowników. Krótko mówiąc, to skuteczne SEO przekłada się na więcej odbiorców, lepsze doświadczenie użytkownika i większe szanse na biznesowy sukces online.

Kontekst

Optymalizacja pod kątem wyszukiwarek od lat przyciąga uwagę zarówno praktyków marketingu, jak i naukowców. Już w latach 90. webmasterzy zdali sobie sprawę, jak ważne jest wysokie miejsce w wynikach i zaczęli eksperymentować z różnymi technikami, aby to osiągnąć. Z czasem powstały setki poradników i badań wskazujących potencjalne czynniki rankingowe – od słów kluczowych w treści, przez linki przychodzące, po szybkość działania strony. Problem w tym, że algorytmy wyszukiwarek są okryte tajemnicą i ciągle się zmieniają. W efekcie wiele wcześniejszych prac miało charakter teoretyczny lub skupiało się na pojedynczych aspektach SEO.

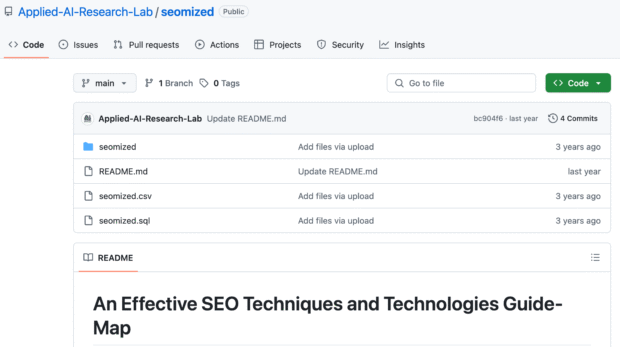

Najnowsza publikacja „An Effective SEO Techniques and Technologies Guide-map” stanowi przełomowe podejście, bo łączy perspektywę teoretyczną z praktyczną. Autorzy dokonali obszernego przeglądu znanych technik SEO (zarówno związanych z treścią, jak i technologiami strony), a następnie sprawdzili, jak te zalecenia realizują w praktyce najpopularniejsze witryny. Innymi słowy, ta praca nie tylko podsumowuje dotychczasową wiedzę, ale też wypełnia lukę między tym, co mówią podręczniki SEO, a tym, co faktycznie robią liderzy rynku. Co więcej, autorzy stworzyli własne narzędzie badawcze i z jego pomocą przeanalizowali bezprecedensowo dużą próbę stron. Dzięki temu publikacja oferuje swego rodzaju „mapę drogową” skutecznego SEO opartą na realnych danych, a nie tylko na intuicji ekspertów.

Metoda badawcza

Aby dowiedzieć się, które techniki SEO rzeczywiście przynoszą efekty, badacze sięgnęli po dane z prawdziwego internetu. Wykorzystali ranking Alexa (już nie istniejący) i zgromadzili listę 2000 najpopularniejszych witryn internetowych (reprezentujących różne branże, przy czym znaczna część to duże sklepy online). Następnie za pomocą własnego programu nazwanego SEOmized przeskanowali każdą z tych stron pod kątem obecności 17 kluczowych elementów SEO.

Badanie objęło zarówno klasyczne techniki on-page, jak i elementy technicznego SEO strony. Poniżej kilka przykładów sprawdzanych aspektów:

- Tytuły stron i meta opisy – czy każda strona posiada unikalny tytuł <title> oraz opis meta opisujący jej zawartość.

- Przyjazne URL-e – struktura adresów URL (czy są krótkie, zrozumiałe i zawierają słowa kluczowe).

- Optymalizacja grafik – obecność opisów alternatywnych (alt) dla obrazków oraz tagów tytułowych linków (atrybut title), co ułatwia zrozumienie treści przez boty i użytkowników.

- Pliki pomocnicze – obecność pliku robots.txt (wskazówki dla robotów indeksujących) oraz mapy strony (sitemap) i ewentualnie kanału RSS do dystrybucji treści.

- Dane strukturalne – użycie znaczników schema.org (np. oceny, recenzje w postaci gwiazdek) oraz protokołu Open Graph do lepszej prezentacji linków w mediach społecznościowych.

- Dostosowanie do mobile – czy strona ma responsywny design (przyjazny na urządzeniach mobilnych) lub korzysta z technologii AMP (Accelerated Mobile Pages) przyspieszającej ładowanie na smartfonach.

- Wydajność i bezpieczeństwo – czy witryna działa na bezpiecznym protokole HTTPS, czy stosuje kompresję (Gzip), cache’owanie i minifikację kodu (CSS/JS) w celu przyspieszenia ładowania, a także czy korzysta z sieci dostarczania treści (CDN) dla szybszego serwowania zasobów.

Lista analizowanych czynników SEO była zatem bardzo szeroka – od optymalizacji treści po zaawansowane usprawnienia techniczne. Co ważne, autorzy skupili się wyłącznie na technikach White Hat SEO, pomijając metody uznawane za niezgodne z wytycznymi wyszukiwarek (tzw. Black Hat SEO, jak np. ukrywanie tekstu czy farmy linków). Dla pełniejszej oceny do narzędzia SEOmized zintegrowano również oficjalne API Google – Mobile-Friendly Test (sprawdzający mobilną użyteczność strony) oraz PageSpeed Insights (mierzący szybkość działania) – tak, aby automatycznie ocenić wydajność i responsywność każdej witryny. Zebrane wyniki zostały zapisane w bazie danych, gdzie dla każdej strony odnotowano binarnie, które z 17 badanych technik są wdrożone (wartość 1) lub nie (0). Taka struktura pozwoliła później z łatwością policzyć, jak często poszczególne praktyki SEO występują na najlepszych stronach.

Główne odkrycia

Jakie są wyniki tej analizy? Okazało się, że największe i najpopularniejsze witryny niemal zawsze stosują podstawowe filary SEO, podczas gdy mniej standardowe rozwiązania są wdrożone rzadziej. Poniżej zestawienie najważniejszych obserwacji:

Najczęściej stosowane techniki SEO

- Przyjazne dla SEO adresy URL – niemal 99% przebadanych stron miało uporządkowane, czytelne adresy linków zamiast przypadkowych ciągów znaków. To pokazuje, że klarowna struktura URL (np. mojadomena.pl/kategoria/produkt) jest dziś standardem wśród liderów rynku.

- Szybkie ładowanie strony – około 94% witryn osiągało bardzo dobre wyniki pod względem szybkości działania. Topowe strony inwestują w rozwiązania przyspieszające, takie jak cache, minifikacja czy wydajne serwery, wiedząc że wydajność jest kluczowym czynnikiem doświadczenia użytkownika i rankingu Google.

- Bezpieczny protokół HTTPS – 86% stron działało w oparciu o HTTPS, zapewniając szyfrowane połączenie dla użytkowników. Obecnie certyfikat SSL to praktycznie obowiązek – nie tylko ze względów bezpieczeństwa, ale i dlatego, że przeglądarki oznaczają strony bez HTTPS jako niebezpieczne, a Google daje stronom na HTTPS drobną premię w rankingu.

- Unikalne meta tagi – zdecydowana większość topowych witryn dba o podstawowe metadane: 78% posiada poprawnie wypełniony tytuł strony (<title>), a około 69% prezentuje unikalny meta description opisujący zawartość strony. To wskazuje, że choć meta tagi to stare, proste elementy SEO, wciąż są powszechnie stosowane jako ważny element optymalizacji.

- Mobile-friendly design – ok. 64% stron cechuje się responsywną budową, dostosowaną do ekranów urządzeń mobilnych. Co prawda odsetek ten mógłby być wyższy (ponad jedna trzecia stron w próbie nie spełniła automatycznego testu mobilności), ale wynik mógł być zaniżony przez ograniczenia narzędzia – część witryn wymagała ręcznej weryfikacji. Niemniej, większość liderów rynku zapewnia dobrą obsługę na smartfonach, co jest spójne z kierunkiem, w jakim od lat zmierza internet (mobile-first indexing w Google).

Najrzadziej stosowane elementy

- Accelerated Mobile Pages (AMP) – wdrożenie tej specjalnej technologii przyspieszonych stron mobilnych stwierdzono jedynie na ~1,7% badanych witryn. To bardzo niski odsetek, sugerujący że po początkowej modzie AMP nie zdobyło szerokiej adopcji poza specyficznymi serwisami (np. wydawcami newsów).

- Atrybuty title linków – tylko około 11% topowych stron korzysta z dodatkowych tytułów w znacznikach <a> (opisujących dokąd prowadzi link). Większość serwisów najwyraźniej nie uznaje tego za priorytet lub polega na kontekście samego anchor textu.

- Kanały RSS – pomimo ich popularności dekadę temu, obecnie jedynie ~15% liderów rynku udostępnia kanał RSS ze swoimi treściami. Użytkownicy coraz rzadziej korzystają z czytników RSS, stąd wiele stron z nich rezygnuje na rzecz mediów społecznościowych czy newsletterów.

- Minifikacja kodu JS/CSS – tylko ~17% (JS) i ~21% (CSS) witryn aktywnie minifikuje swoje skrypty i arkusze stylów. Ta dość zaskakująca obserwacja może wynikać z faktu, że duże portale często ładują rozbudowane, dynamiczne aplikacje i skrypty, gdzie pełna minifikacja bywa trudna lub zastąpiona innymi formami optymalizacji.

- Znaczniki danych strukturalnych – np. schema.org (czyli dane strukturalne pozwalające wyświetlać bogate wyniki w Google, jak gwiazdki ocen czy informacje o produktach) zaimplementowało tylko ~29% badanych stron. Innymi słowy, mniej niż co trzeci topowy serwis korzysta z mikrodanych czy JSON-LD do oznaczania treści. To wciąż mniejszość – co może oznaczać szansę wyróżnienia się dla tych, którzy jednak zainwestują w tę technikę.

Poza powyższymi, badanie dostarczyło jeszcze wielu ciekawostek. Na przykład znaczniki Open Graph (ułatwiające atrakcyjne prezentowanie linków na Facebooku, Twitterze (X) itp.) wykryto na ok. 39% stron, a plik robots.txt na 67% – co sugeruje, że wciąż spora część witryn nie definiuje jawnie polityki dla botów (być może korzystając z ustawień domyślnych wyszukiwarek). Z kolei link building – choć uznawane za krytyczny czynnik SEO – nie było przedmiotem automatycznej detekcji narzędzia (trudno je ocenić skanując pojedynczą stronę), ale autorzy odnotowali je jako ważny element off-page SEO w analizie literatury. Ogólny obraz wyłaniający się z wyników jest jednak jasny: najlepsze strony internetowe skupiają się na solidnych podstawach SEO (strukturze, treści, wydajności, mobile, bezpieczeństwie), podczas gdy bardziej wyszukane techniki stosują wybiórczo.

Znaczenie wyników

Co oznaczają te wyniki dla branży SEO i marketerów? Przede wszystkim, potwierdzają one intuicję, że fundamenty SEO są obowiązkowe – i każdy, kto chce konkurować o wysokie pozycje, powinien zacząć od ich wdrożenia. Jeśli niemal 99% czołowych serwisów dba o przyjazne URL-e, a ponad 90% o szybkość działania i HTTPS, to znaczy, że bez tych elementów trudno myśleć o sukcesie. Mapa technik SEO opracowana w badaniu wskazuje też ważne priorytety. Te praktyki, które są najpowszechniejsze (widoczne na największym odsetku topowych stron), to najpewniej „must-have” dla każdej witryny. Autorzy podkreślają, że ich rezultaty można traktować jako przewodnik dla webmasterów, jak wychylić się na tle konkurencji – wiedząc, które konkretnie techniki zastosować w pierwszej kolejności.

Z drugiej strony, umiarkowana popularność takich rozwiązań jak AMP czy schema.org sugeruje, że nie każde nowatorskie czy zaawansowane podejście jest niezbędne dla wszystkich. Dla praktyków SEO to cenna wskazówka. Najpierw zadbaj o podstawy, potem dopiero eksperymentuj z „ficzerami”. Ograniczone zasoby (czas, budżet) lepiej inwestować tam, gdzie zwrot jest najbardziej prawdopodobny. Na przykład, jeśli ponad 2/3 stron ma meta opisy, a tylko 1/3 bawi się danymi strukturalnymi, to lepiej najpierw napisać dobre opisy i tytuły, zanim zabierzemy się za implementację skomplikowanego schematu JSON-LD.

Wyniki tego badania mają jeszcze jeden, szerszy wymiar. Pokazują, że SEO dojrzewa jako dziedzina oparta na danych. Zamiast polegać wyłącznie na domysłach i „best practices” przekazywanych na konferencjach, można empirycznie sprawdzić, co robią najlepsi. Co więcej, autorzy udostępnili swoje narzędzie SEOmized (https://github.com/Applied-AI-Research-Lab/seomized) oraz zebrany zbiór danych publicznie (https://github.com/Applied-AI-Research-Lab/seomized/blob/main/seomized.sql), dzięki czemu inni specjaliści mogą z nich skorzystać i analizować dalsze zależności. Dla branży SEO to krok w stronę większej transparentności i mierzalności: strategie mogą być planowane na podstawie twardych danych o tym, co faktycznie działa na rynku.

Najważniejsze przesłanie płynące z pracy Roumeliotisa i Tselikasa jest takie, że nawet mała firma czy początkujący webmaster – dysponując wiedzą o sprawdzonych technikach – może poprawić swoją widoczność. Nie trzeba zgadywać ani mieć wieloletniego doświadczenia, bo wystarczy spojrzeć, jakie elementy zoptymalizowali ci, którym już się powiodło, i naśladować ich podejście. Zgodnie z wnioskami autorów, podążanie ścieżką wytyczoną przez topowe witryny powinno przełożyć się na wyższe pozycje w SERP-ach i większy ruch, nawet jeśli nie dysponujemy sztabem specjalistów SEO. Oczywiście, każdy projekt jest inny, ale wiedza o tym, co jest normą w branży, daje solidną podstawę do budowy własnej strategii optymalizacji.

Dyskusja

Warto krytycznym okiem spojrzeć na ograniczenia i kontekst tych badań. Po pierwsze, analiza objęła 2000 topowych stron świata, a więc głównie gigantów internetowych i popularne portale. Takie serwisy z reguły mają rozbudowane zespoły i zasoby, co pozwala im wdrażać wiele usprawnień – mniejsze witryny nie zawsze stać na pełen pakiet optymalizacji. Z drugiej strony, duże marki mogą cieszyć się wysoką pozycją częściowo dzięki rozpoznawalności i lojalnej bazie użytkowników, a nie tylko samym technikom SEO. Innymi słowy, korelacja nie zawsze oznacza stuprocentową przyczynowość. Fakt, że czołowe strony coś robią, nie gwarantuje sukcesu, jeśli pominiemy np. jakość treści czy atrakcyjność oferty. Mimo to, trudno zaprzeczyć, że brak tych elementów może zaszkodzić – dlatego lepiej je mieć niż nie.

Kolejnym wyzwaniem jest dynamiczność SEO. Algorytmy Google ewoluują kilkaset razy do roku, a w ciągu paru lat potrafią zmienić akcenty (choćby rosnące znaczenie Core Web Vitals czy też zmniejszenie roli AMP). Badanie odzwierciedla stan na rok 2022; od tego czasu adoptowalność niektórych technik wzrosła (np. więcej witryn mogło wdrożyć schema.org, gdy stało się jasne, że pomaga to w wyróżnieniu wyników). Dlatego „mapa” technik SEO nie jest stała – powinna być aktualizowana wraz z trendami. Na szczęście metoda zaproponowana przez autorów może służyć jako szablon, bo podobne badania da się przeprowadzać cyklicznie, aby śledzić, które taktyki zyskują, a które tracą na znaczeniu.

W pracy nie uwzględniono też pewnych aspektów, które trudniej zmierzyć automatycznie, np. jakości i długości contentu, linkowanie wewnętrzne i jego struktura czy doświadczenia użytkownika na stronie (poza czysto technicznym UX jak szybkość czy mobile-friendly). Te czynniki również są istotne dla SEO, ale wymagają bardziej złożonych analiz (często jakościowych lub z wykorzystaniem AI oceniającej treść). Dlatego przyszłe badania mogłyby rozszerzyć zakres o ocenę zawartości merytorycznej stron albo efektów działań off-site (profil linków zwrotnych, obecność w social media).

Co ciekawe, autorzy artykułu przeprowadzili także odrębne case studies dla specyficznych sektorów – np. linii lotniczych czy hoteli – wykorzystując podobną metodologię. To pokazuje, że jeden uniwersalny przepis na SEO może nie istnieć, a specyfika branży ma znaczenie. Niemniej jednak, większość podstaw (szybkość, mobile, bezpieczeństwo, treść) jest wspólna dla wszystkich. Wyzwaniem dla marketerów pozostaje więc znalezienie właściwego balansu, czyli które techniki są krytyczne akurat dla naszej domeny, a które mogą poczekać.

Na koniec warto podkreślić, że badanie Roumeliotisa i Tselikasa skupiało się wyłącznie na White Hat SEO, czyli metodach zgodnych z wytycznymi Google. Black Hat SEO, choć czasem kuszące dla szybkiego efektu, zostały pominięte – słusznie, bo ich krótkotrwałe korzyści nie równoważą ryzyka kar od wyszukiwarek. To przypomina, że długofalowo opłaca się grać fair, czuli budować wartościową treść i ulepszać stronę dla użytkowników, zamiast szukać drogi na skróty.

Zakończenie

Badanie „An Effective SEO Techniques and Technologies Guide-map” to cenna lektura zarówno dla akademików interesujących się technologiami webowymi, jak i dla praktyków SEO oraz marketerów cyfrowych. W przystępny, oparty na danych sposób pokazuje ono co dziś naprawdę działa w SEO. Uzyskana „mapa” skutecznych technik może służyć jako plan działania dla każdego, kto chce poprawić widoczność swojej witryny – od małego bloga po sklep internetowy. Choć świat SEO ciągle się zmienia i zawsze pozostanie w nim element niepewności, jedno jest pewne, że świadome korzystanie ze sprawdzonych praktyk daje przewagę. Dzięki takim badaniom jak ta, zamiast błądzić po omacku, możemy kierować się sprawdzonymi wskazówkami. Warto więc na bieżąco śledzić zarówno zmiany w algorytmach, jak i wyniki kolejnych badań SEO – bo wiedza jest najlepszym kompasem w szybko zmieniającym się krajobrazie marketingu w wyszukiwarkach.

Dane techniczne

- Tytuł publikacji: “An Effective SEO Techniques and Technologies Guide-map”

- Autorzy: Konstantinos I. Roumeliotis, Nikolaos D. Tselikas

- Źródło: Journal of Web Engineering, vol. 21, nr 5 (2022), s. 1603–1650

- DOI: https://doi.org/10.13052/jwe1540-9589.21510

Zapisz się na newsletter wypełniając pola poniżej. Będziesz na bieżąco ze wszystkimi wydarzeniami związanymi z Silesia SEM i informacjami o marketingu internetowym w sieci. Nie spamujemy.

Zostanie wysłany do Ciebie e-mail potwierdzający: przeczytaj zawarte w nim instrukcje, aby potwierdzić subskrypcję.

Artur Strzelecki

Ostatnie wpisy Artur Strzelecki (zobacz wszystkie)

- Black Friday SEO 2025 - 28 listopada 2025

- Druga część webinaru z autorami książki „SEO w praktyce” - 25 listopada 2025

- Rewolucja w wyszukiwaniu: tryb AI Google wkracza do Polski – co musisz wiedzieć? - 8 października 2025